想要治理AI,我们还得靠AI本身

Terence Tse

Executive Director, Nexus FrontierTech, Professor of Finance, Hult International Business SchoolMark Esposito

Faculty Associate, Harvard Center for International Development, Harvard Kennedy School of Government数据统治了我们的生活,因为它不仅能告诉公司我们的需求,还能帮助我们记录并分类所求、所需、所忽视的事物。所有的决定都会被模式替代,而模式合在一起就是我们自身的样子。现在,我们被各种模式环绕,甚至被其赶超——在餐厅里,我们会让其知道我们是否有过敏史;在零售店里,我们会让其知道我们喜欢的服装尺码。这样的世界运行方式已摆在我们眼前,如果还有人将其标榜为科幻小说,那他不是缺乏想象力,而是缺少对世界的认识。

有了人工智能带来的好处,我们的选择已变得更加容易、便捷,同时,客户选择方面的竞争也有所加强。在发展过程中,我们所关心的问题并非人工智能会在多大程度上影响我们的选择,而是它改变选择的方式。在这样一个世界里,我们必须试着了解,究竟是谁在什么时候改变了我们的行为?

很显然,在一个由人工智能塑造选择的世界里,大多数人都安分知足。我们生活的世界的确是这样的:从搜索引擎到畅通的交通,大部分日常便利设施都是基于后台提供的速度而建造的。在人工智能及其管理方面,我们得问问自己,在一个连我们自己都不知道是否被影响、以什么方式被影响的世界里,我们能够舒适地生活吗?

行为偏见还是行为线索?

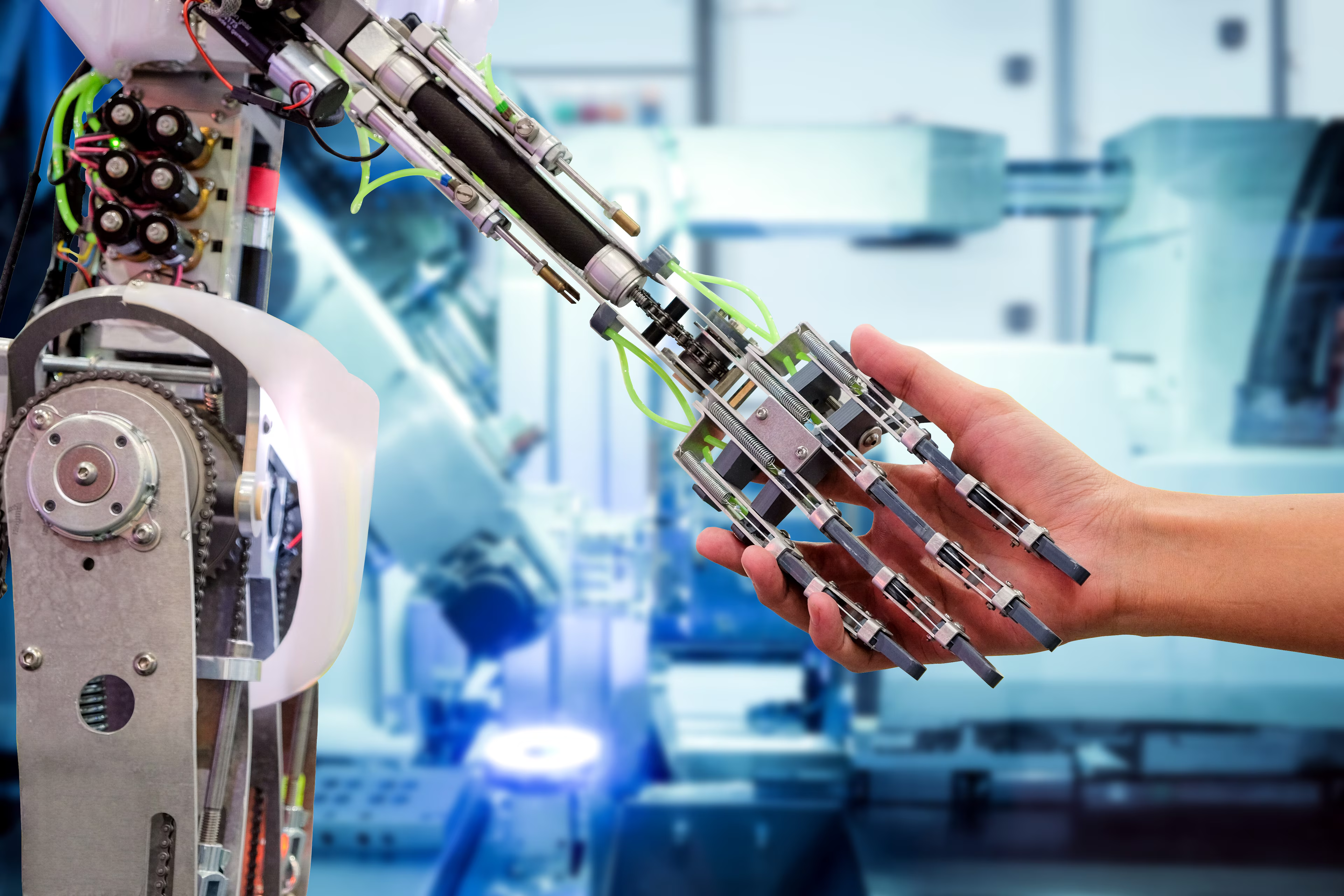

就像显微镜对生物学作出的贡献那样,人工智能将进一步帮助理解人们的行为。

现在,软件已经能够识别出那些我们自己可能都注意不到的行为模式倾向,识别那些朋友、家人也不知道的人格特征。对于这种情形,有一个低劣的杜撰故事可以让我们先睹为快:在收到了Target提供的儿童用品广告(Target检测到了女儿开支项的变化)后,父亲才发现女儿怀孕了。[i]

我们的生活已然被促使行为发生的那些概率假设所控制。现在,我们必须扪心自问,到底愿意让生活中的多少事物被那些难懂的算法所改变?更重要的是,当算法给出了错误或故意操纵的决定后,谁来负责对此进行标记?

越来越多的公司都开始使用人工智能,而了解人工智能的过程也正变得越来越复杂,因此,我们将面临一个关于理解权、告知权的断层——一个关于违例是否发生、何时发生的断层。

数字化的存在感不断增强,而这种存在感正在被未来电子监管的公共导向以及利益处理的私人导向所推动。有意义的监管必定包含这样的第一步:人们拥有获取数据使用方式、使用者、使用时间等信息的权利。

行为和科技正以史无前例的速度相互作用,对此,正在为我们提供服务的Chatbot提供了另一项例证。Chatbot向我们证明,科技拥有情感联想的潜力,而情感联想可以用来进行操控。[ii] 自然语言处理正朝着高级机器人技术的方向发展,因此,和触感、温度、舒适度紧密联系的建筑潜力也有所提升,尤其是在这个孤独泛滥的世界里——英国甚至真的任命了一位孤独部长。

随着物联网内机器和机器数据的发展,拥有优惠性进入政策的公司将观察到越来越多行为模式方面的微小角度,有些甚至我们自己都不能理解——与此同时,轻推行为的强大能力也随之到来。货物数据并不止关乎体量,还涉及到真实性。物联网壮大之后,我们已将公司所需的关于我们的信息都放在了银盘上。

除了体量,这件事还关乎货物管理过程中分析能力的不对等性,即获取价值的不对等性。相应地,这意味着有些公司不仅了解你,还能预测你的行为,以至于推断出影响某一特定行为的最有效的方法。在大数据时代,最好的业务就是洞察业务。

问责:谁来照顾我们?

建立责任制方面的第一个问题是,人工智能已经让决策过程趋于自动化,那该如何让人们紧握决策环?下一步则是在理解权中保留责任制,其中,理解权指的是人们拥有理解为什么该算法作出了这个、而非其他决定的权利。

对此,人们提出了很多新的建议。比如,当某一个人工智能项目成为公司竞争力的专有组成部分后,我们就可以利用反事实系统获取人工智能所面临的所有选择。[iii] 不过,在没有打破黑匣子的情况下,规划出来的决策并不能提供算法运算的根据。

此外,该问题还可以挖掘得更深入一些。在透明模型方面,人们面临的问题是,到底应该找什么?什么时候应该决定停止使用公司的数据?在不远的将来,我们可能无法理解,人工智能到底是如何影响我们自身的。

由此,我们触及到了一个根本性的问题:为了治理人工智能,我们可能还得靠人工智能本身。

我们不仅要用人工智能来理解自己是如何被公然改变的,还要靠它理解,公司是如何通过新兴的方法来影响我们行为中的微观理解的。对于为了操纵而使用的人工智能,当前的法律框架、政治体制、问责标准仍然缺乏相关的理解、预测、获取能力。

当卡特尔定价被不断出现却随时消失的定价问题取代后,算法合谋已经成为了一个严重的问题。这类定价问题无法签署事前协议,也不存在初步的索赔要求。[iv] 试想,如果有组织的合谋并非来自于自市场,而是通过不同群体的行为追踪来进行微小的价格改变,那会如何?

相关阅读:

到了这一步,问题已自然地浮出水面:谁来管理那些我们用于管理人工智能的人工智能?我们怎么知道监管者和被监管者之间不会出现合谋?为了在最大程度上减少对人工智能透明度的要求,我们应该为监管型人工智能安排哪种透明度系统?

人工智能治理的未来将就此决定——我们需要注意的并不是合谋、操控的多变结构,而是称职的人工智能应有的行为和能力:它们能否以最少的影响点来塑造决策?

我们必须进行沟通,从而透彻地了解关于定价、合谋、操纵的各种假设与意见。在人工智能时代,我们承受不起模糊带来的代价。

作者:Josh Entsminger,应用研究员

Mark Esposito,哈佛大学继续教育学院

Terence Tse,欧洲高等商学院伦敦校区金融学副教授

Danny Goh,连续创业家、早期投资者

以上内容仅代表作者个人观点。

本文由The Decision Lab发布,转载请注明来源并附上原文链接。

翻译:叶枫

责编:万鸿嘉

世界经济论坛博客是一个独立且中立的平台,旨在集合各方观点,讨论全球、区域及行业性重要话题。

不要错过关于此主题的更新

创建一个免费账户,在您的个性化内容合集中查看我们的最新出版物和分析。

许可和重新发布

世界经济论坛的文章可依照知识共享 署名-非商业性-非衍生品 4.0 国际公共许可协议 , 并根据我们的使用条款重新发布。

世界经济论坛是一个独立且中立的平台,以上内容仅代表作者个人观点。

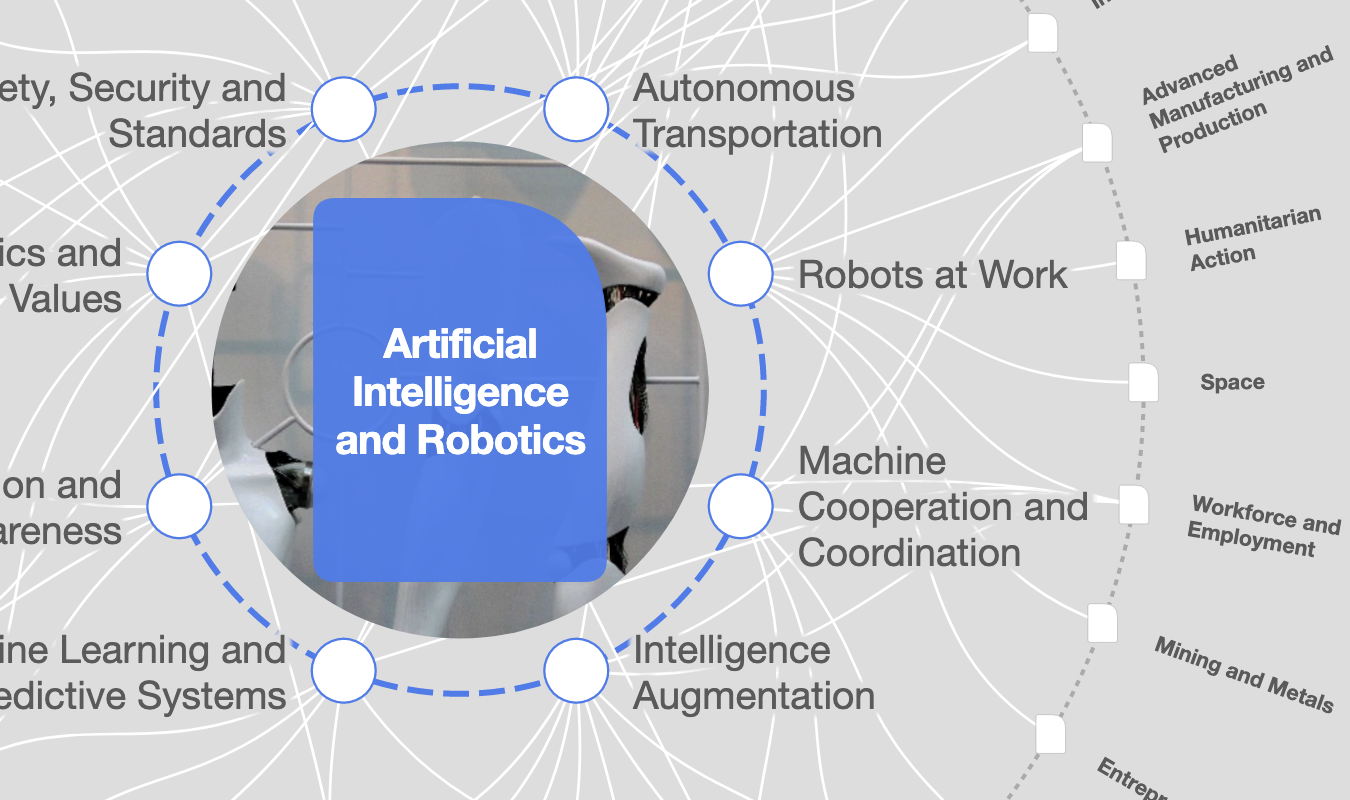

实时追踪:

人工智能与机器人

分享:

每周 议程

每周为您呈现推动全球议程的紧要问题(英文)