面对AI超人类的说服力,我们如何保持自主性?

技术发展速度持续超越当前的人工智能治理体系。 Image: REUTERS/Aly Song

- 人工智能(AI)等技术能帮助人们更有效地沟通交流。

- 但不法分子也可以通过多种方式利用AI传播虚假信息和错误信息。

- 全球领袖不仅需要洞察AI技术的潜力,也需要利用技术来促进信任与合作。

想象这样一个场景:你正在向全球领袖发表演讲,现场配备同声传译。但这位译员并非将内容翻译成不同外语,而是将你的演讲个性化翻译为符合每位听众自身道德框架的内容。

当你提出新的和平倡议或企业政策时,译员会将论点翻译为针对每位听众的个性化信息,以期说服他们。它还会实时测试这些信息,观察哪种话术能引发听众心率加速。

正如算法测试哪些视频能让你看更久,这些AI翻译将判断哪些信息能让你更投入。虽然这目前只是虚构场景,但未来完全可能实现。

关键问题是:谁控制着这位“译员”?

作为拥有二十余年为全球领导人提供影响力沟通咨询经验,且在该领域运用AI逾五年的资深顾问,我坚信技术能助力人类更高效地沟通。但我也清晰预见恶意行为者滥用技术的风险。

全球领袖既需洞悉技术的潜力,更要掌握通过对技术的有效治理来促进信任与合作。

如何说服别人

在哈佛大学肯尼迪学院教授研究生说服力与影响力课程时,我们研习亚里士多德等历久弥新的说服力框架:信誉(ethos)、逻辑(logos)与情感(pathos)。充分发挥这三要素的力量,便可赢得受众的情感与理性认同。

在传授这些理论时,我告诫学生:至今没有人知道何种论据能说服所有人,因为是否说服他人取决于个体的背景、信念与经历。“幸而我们无从知晓,”我强调,“否则掌握这种能力的人将拥有任何凡人都无法拥有的绝对力量。”

但这种力量如今已然存在。我称之为“亚里士多德算法”——将古代说服力原理嵌入AI,实现超人类的规模化运作。两千三百年来,亚里士多德的劝说模式始终受限于单一发言者、单一信息的局限。AI正突破诸多限制,引发深刻的伦理问题。

当亚里士多德算法大规模运行时,每个个体都将置身于独立的劝说现实中。

AI的说服力

世界经济论坛《2025年全球风险报告》指出,虚假信息、错误信息是当前全球首要短期风险。生成式AI的武器化正是该风险的核心驱动因素。OpenAI旗下GPT-4于2024年发布的一项研究发现,当模型获取人物背景信息后,其说服力较人类提升82%。这意味着当AI接触个人数据时,其说服力将远超人类。

根特大学研究人员在2024年11月的调查报告中警示:“基于大语言模型的说服手段蕴含深远的伦理与社会风险,包括虚假信息扩散、偏见放大及隐私侵犯等。这些风险凸显了制定伦理准则与更新监管框架的紧迫性。”

与此同时,关于AI说服力的最关键发现之一是:当人们意识到自己面对的是AI而非人类时,其说服力会显著降低。这表明欺骗性是专家们担忧的操纵手段的核心要素,尤其在虚假信息与错误信息传播领域。

因此,当AI系统掌握你的投票记录与消费习惯,并能根据社交媒体活动构建心理画像时,其精准说服能力将达到前所未有的高度,且能以指数级规模实施。

从某种角度看,亚里士多德算法的运用可能挽救数百万生命。试想世界卫生组织向数百万民众传播疾病预防措施时,一条信息能根据个人特征即时“翻译”成不同说辞。

但另一方面,谁能阻止个人或机构利用这种力量操纵你,迫使你为其利益、而非自身利益采取行动?

当今领袖掌握着超越人类的说服工具,但这些工具的开发过程缺乏透明度,其使用时机与方式的披露标准也未达成共识。这些AI系统将为我们诠释世界,从而影响数十亿人的信念。

我们应当就这些AI系统的部署建立怎样的共识?在AI治理中,又有哪些防护措施能防止某个不法员工手动篡改模型参数?

负责任的AI治理

在技术问题上,我自认是位以人为本的乐观主义者。决定性因素在于我们如何运用这些工具。未来两年关于AI的决策,包括模型训练过程的透明度与数据使用规则的清晰度,将决定人类历史的未来轨迹。我的著作《AI赋能真诚领导者:如何在保持人性化的同时提升沟通效能》聚焦这些议题,探讨了领导者如何运用生成式AI进一步强化跨文化沟通中的真诚、信任与交流。

有许多解决方案。如在AI系统上添加“成分标签”以展示数据使用方式,或在类似于美国政治广告的数据使用时要求信息披露,或赋予个人数据自主权使其能决定数据何时及如何被他人使用。任何方案都需理解技术运作机制,并对社会影响保持深刻洞察。

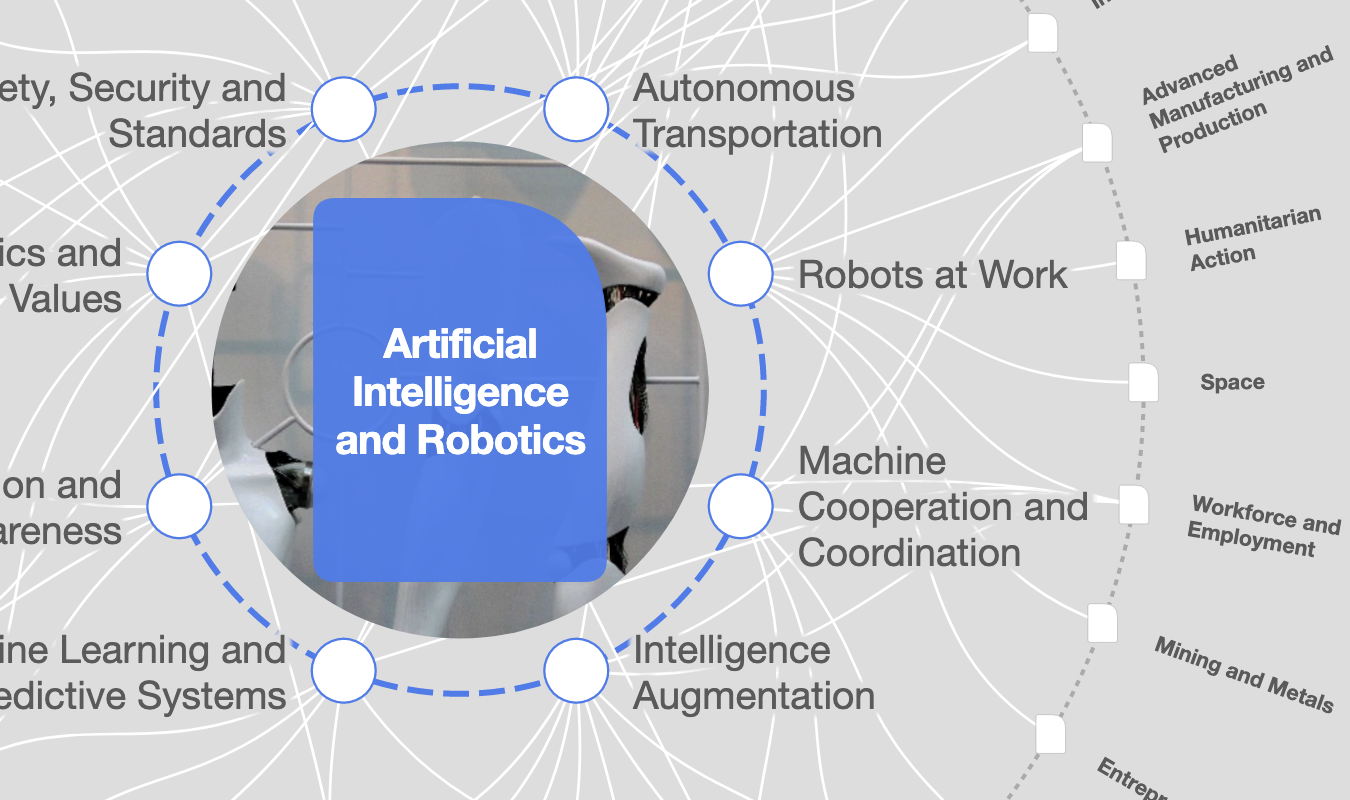

随着技术发展速度持续超越现有AI治理体系发展速度,时间已成关键。世界经济论坛将于2026年1月召开2026年世界经济论坛年会,届时全球领袖将齐聚一堂,共同探讨如何为AI设定边界以守护人类能动性。他们将开启关于AI与影响力的全新对话,构建AI治理原则,以确保这项技术服务于真相、透明度与人类能动性,而非操纵或控制。

若下一个领导力时代意味着超人类的说服力,那么我们也必须兼备超人类的责任感。我们面临前所未有的机遇,需要重新定义未来的说服力,让大家听到每种语言真诚的每种声音。

本文作者:

Allison Shapira,哈佛大学肯尼迪政府学院公共政策讲师

本文原载于世界经济论坛Agenda博客,转载请注明来源并附上本文链接。

每周 议程

每周为您呈现推动全球议程的紧要问题(英文)

更多关于 人工智能查看全部

Kaiser Kuo

2026年2月12日