银行如何预防机器人失控

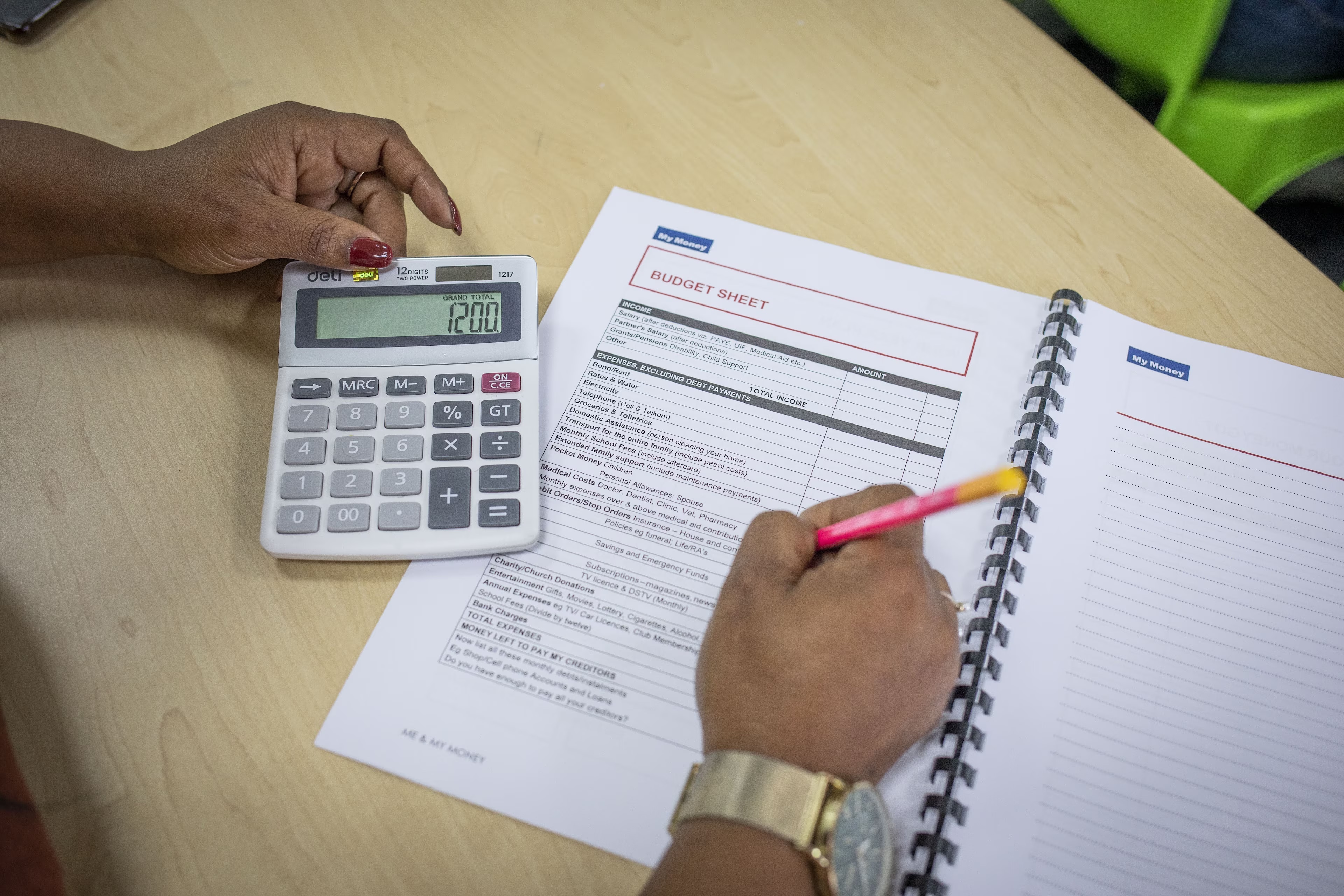

如果机器开始给出不适当的投资建议,投资风险便会急剧上升。 Image: 路透社/Tyrone Siu

多家银行纷纷推出机器学习应用程序,以处理原本应由人工完成的各项工作,包括客户服务到自动投资选择。但假如机器人一旦失控,他们是否做好收拾残局的准备了呢?

虽然许多金融服务公司已经使用完善的系统来监管人为违规操作,且近年来这些系统已被用于社交媒体和其他新技术领域,但机器不当行为则是另一回事。站在合规、风险管理、人力资源和技术的十字路口,机器行为管理在大多数银行的管理体系中并不占有一席之地。

银行若要开发机器学习应用程序的无限潜力,就需要改变现状。这些技术若能得到正确运用,便能给银行和客户带来巨大利益。机器学习应用程序能让客户更好地了解情况,提供更优的解决办法,提高从客户界面到后台办公功能等方方面面的效率。

但银行应像其积极审查求职者的工作背景、道德品质及求职者是否适合这份工作一样审视机器学习应用程序的道德影响。一个坏了的机器人便会损害银行的声誉,并且可能造成收入损失。由于机器的不当行为是单纯的技术现象,其导致的问题往往会立刻传播开来,从而引发连锁反应,对组织和客户造成大规模影响。

即使是技术巨头也会在机器学习领域犯错。近日,苹果Siri搜索工具对“母亲”的定义出现故障,而Google的照片应用中出现了种族问题上的失误。

那么,银行如何能在推动创新和利用机器学习巨大潜力的同时加强机器风险管理呢?

首先,银行应针对其机器学习行为制定强大的机器研发和数据管理标准。这要从列出银行现有的应用程序清单做起。在许多银行中,不同的团队各自推出新的应用程序。他们需要全公司的视野。

其次,银行必须深入研究数据。他们已经对市场和每天流动的其他数据建立了深入理解,但机器学习应用程序正在引入大量需要编目和监控的新社交媒体和客户界面数据。这些新的数据表单和交易与金融数据一样需要同等级别的管理。个人或团队必须不断筛查可能会影响机器学习应用程序结果的内容。

在引入新的应用程序前,银行还应建立审核和批准流程,从而平衡整个公司对合适的风险管理和推动创新的需要。每个应用程序都有可能在生态系统中引入新的数据和决策,从而破坏其他功能。

银行还必须为机器故障负责。它们已经拥有针对员工的长期管理程序:人力资源部门管理行为和其他道德考量标准;合规性审计保证员工遵守公司和管理规定;行为小组管理与客户之间的联系;而风险小组确保销售的产品不会将公司置于风险之中。

类似地,银行还需要机器学习应用程序的分类,详细说明管理和控制各种机器所带来的风险的角色、责任和流程,当一台新机器对客户提出不当的投资建议时,这种风险有可能急剧上升。人们会将矛头指向技术团队,而技术团队会将责任转移到销售团队或模型风险管理团队身上。合规小组和其他小组可能根本不会参与其中。

为了保证银行能够采取适当的反应措施,他们必须提升每个管理职能的技术水平,从风险管理到合规再到人力资源都应如此。银行需要聘请数据科学家和相关领域技术人员,以便提出正确的问题,并通知监管部门。

最后,在决策中使用机器学习还存在一些道德考虑,高级管理团队应积极参与到框架的开发中。

机器学习应用程序能让银行用新的方式为客户、员工、股东和社会创造价值。但银行必须意识到机器学习的风险,并迅速、系统地应对风险。如果没有合适的管理,过不了多久,机器学习便会带来重大的伦理、法律和金融方面的灾难结果。

作者:Elizabeth St-Onge,奥纬咨询公司金融服务部合伙人

Ege Gürdeniz,奥纬咨询公司数据、技术和分析部部长

以上内容仅代表作者个人观点。

本文由世界经济论坛原创,转载请注明来源并附上原文链接

编辑:万鸿嘉

世界经济论坛是一个独立且中立的平台,旨在集合各方观点讨论全球、区域及行业性重要话题。

不要错过关于此主题的更新

创建一个免费账户,在您的个性化内容合集中查看我们的最新出版物和分析。

许可和重新发布

世界经济论坛的文章可依照知识共享 署名-非商业性-非衍生品 4.0 国际公共许可协议 , 并根据我们的使用条款重新发布。

世界经济论坛是一个独立且中立的平台,以上内容仅代表作者个人观点。

实时追踪:

银行及资本市场

分享:

每周 议程

每周为您呈现推动全球议程的紧要问题(英文)